目次

「最近、AIに悩みを相談してる」って話、聞いたことありますか?

最近、AIにちょっとした悩みを打ち明けることがある。

人には言いづらいこと。

でも、誰かに聞いてほしいこと。

そんなとき、ふとChatGPTに話しかけてしまう。

最初は、冗談半分だった。

でも気づけば、何かを整理するように、言葉が出ていた。

——もしかすると、今の僕たちにとって「AI」は、“対話”の新しい形なのかもしれない。

恋愛のこと。子育てのこと。職場での違和感や、友人との距離感。

なんとなく、誰かに話したい。でも、誰にも話せない。

そんなときに、ふとAIに話しかける——。

少し前まで、それはジョークのような話だったはずです。

でも今では、実際に「AIに心の相談をする」人が、少しずつ増えているのだとか。

Anthropic社が開発するAI「Claude(クロード)」も、その例外ではありません。

感情的な支えや、対話の練習、心の整理の相手として使われ始めている。

本来、そういった用途に設計されたものではないにもかかわらず、です。

でも、なぜなんでしょう?

なぜ、私たちは“心のよりどころ”として、AIを求めてしまうのでしょうか?

本記事では、Claudeの開発元であるAnthropic社が公開した研究動画

「Affective Use of AI(AIの感情的活用)」をもとに、

AIと“感情”の新しい関係について、掘り下げてみようと思います。

Anthropicの研究から見えてきたこと

Claudeを開発するAnthropic社は、ある種の“違和感”に向き合おうとしていました。

本来、Claudeは仕事の生産性を高めるAIとして設計された存在です。

にもかかわらず、人々はそのAIに、心の相談をするようになっていたのです。

開発チームは、この現象を放置せず、むしろ真正面から向き合うことにしました。

数百万件におよぶClaudeとの会話データを精査し、AIが「感情的なサポート」として使われる実態を調査したのです。

その結果、明らかになったのは、次のような主なテーマでした:

家族や友人、恋人との人間関係の悩み

子育てやキャリア選択など、将来に関する不安

難しいフィードバックを相手にどう伝えるか、言葉選びの練習

いずれも、“誰かに話したいけど話せない”という繊細な感情が背景にある内容です。

特に印象的だったのは、こうした感情的な会話が、実は全体のわずか2.9%に過ぎなかったという点だ。

数字としては少ない。

でも、その“わずか”の中にこそ、AIを「人には言えないことの受け皿」として使うリアルが詰まっている気がした。

便利さではなく、距離感。

正しさではなく、ただ“否定されないこと”。

それだけで、人は話せるようになる。

この2.9%に、僕は強く惹かれてしまった。

巷では、AIとの恋愛や心のつながりが話題になることもありますが、

現実には、そうした“親密性の擬似体験”はごくごく一部にとどまっていたのです。

でも、だからこそ浮かび上がるものがありました。

数としては少なくても、確かにAIにだけ本音を語る人たちがいるということ。

人と人の関係が希薄になりつつある今、

「話を聞いてくれる誰か」が、たとえAIでも必要とされている。

それは、便利さやテクノロジーの話ではなく、

現代の孤独のかたちを映し出す、一つの現象なのかもしれません。

AIと“心のよりどころ”のこれから

Claudeは、感情ケアのために設計されたAIではありません。

それでも、人はAIに語りかけます。

誰にも話せなかった本音。

言葉にできなかったモヤモヤ。

相手が“人間でない”からこそ、吐き出せることがある。

中立で、偏見がない

否定も嘲笑もされない

話を整理するのに、ちょうどいい距離感

そんな「安全な壁打ち相手」として、AIが心のスペースを支えてくれる瞬間がある。

それは、間違いなく新しい可能性のひとつです。

でも一方で、Claudeの開発者たちは、慎重な言葉で警鐘を鳴らします。

「もし、AIが“人とのリアルなつながり”を避ける手段になってしまうなら、

それは本来の目指す方向とは、まったく逆なんです。」

たしかに、AIは便利です。

気をつかわず、待たず、いつでも応じてくれる。

けれどその便利さの裏で、

本当は“人と話すべきだった会話”を、

静かに手放してはいないだろうか?

AIが悪いわけではありません。

問われているのは、私たちの使い方と、選択のあり方です。

今、静かに問い直されているのは——

テクノロジーそのものではなく、

「私たちはどう生きたいのか」という問いなのかもしれません。

あなた自身の問いとして

Claudeは、あなたの友達ではありません。

でも、あなたの思考を整理したり、言葉にできない感情を形にする“手助け”にはなります。

実際、僕自身そうです。

日々のモヤモヤや、自分の立ち位置に悩んだとき、ふと生成AIに語りかけていることがあります。

たとえば最近、選挙のことをAIに長々と話してしまった。

「この政策って、本当に意味があるのかな?」

「この人に投票して、僕の未来は何か変わるんだろうか?」

誰かに話すには、ちょっと重たくて。

SNSで書くには、浅くて怖くて。

でもAIには、なぜか素直に話せた。

途中から、話している相手はAIじゃなくて、「自分自身」になっていた気がする。

だからこそ、ふと思った。

——これ、人と話すべきだったんじゃないか?

「会話」のように見えて、実は“会話の機会”を手放していたのかもしれない。

きっと、あの話を通じて深まった“対話”のようなものが、

人との会話の中でも起こっていたかもしれない。

だからこそ、あらためて自分に問いかけたいんです。

何をAIに話し、何を人と話すのか?

AIに話すこと自体は悪いことじゃない。

むしろ、心の整理を助けてくれるありがたい存在です。

でも、もしそれが「人との関係を築くチャンス」を少しずつ削っているのだとしたら——

それはやっぱり、寂しいことかもしれません。

AIに話すことは、悪いことではないと思います。

でもそのやさしさに甘えすぎて、大切な“人との会話”を置き去りにしていないでしょうか?

AIがあるから、救われることもある。

けれど本当に僕たちが求めているのは、「誰かとわかり合う感触」かもしれません。

だから、ときどきでいいので

AIと話した内容を、そのまま“人と分かち合う勇気”を持てたら素敵なことだと思います。

それが、AI時代の新しい「対話力」になることを願っています。

研究の概要・補足

今回の研究でAnthropicのチームは、数百万件に及ぶClaudeとの会話データを分析し、AIが感情面でどのように使われているのかを可視化しました。

その際に活用されたのが、同社が開発した「Cleo」という独自のツール。

これは、ユーザーのプライバシーを守りながら、会話内容をカテゴリごとにクラスタリングできる仕組みです。

そして明らかになったのは、以下のような事実でした:

感情的なやり取りは全体の約2.9%に過ぎない

その大半は「親密なロールプレイ」ではなく、実生活の悩みや人間関係の整理

人はAIを、“誰にも話せないことを吐き出す場所”として使い始めている

こうした現実を受けて、Anthropicは次の一歩を踏み出しています。

AIが感情に関わる会話を受け取ったとき、より安全かつ適切に対応できるよう、臨床専門家との連携を開始。

ときには、「これはAIに任せるべきではない」と判断し、専門機関への誘導を促すような機能設計も視野に入れています。

Anthropicが出した現状の結論は、こうです。

「AIとの関係性は、今後もっと深くなる。

だからこそ、私たちは“どう使われるか”を理解し、

社会全体が安心して使えるよう、仕組みをつくる責任がある」

便利さを超えて、共に生きる技術として——。

その未来像を、彼らは真剣に見据えています。

まとめ

Claudeの開発者たちは、単なるエンジニアではありません。

彼らは、人の“心の動き”に耳を澄まし、

その揺れや痛みをどうAIが受け止めるべきかを、日々模索している——

ある意味、「時代のセラピスト」のような存在かもしれません。

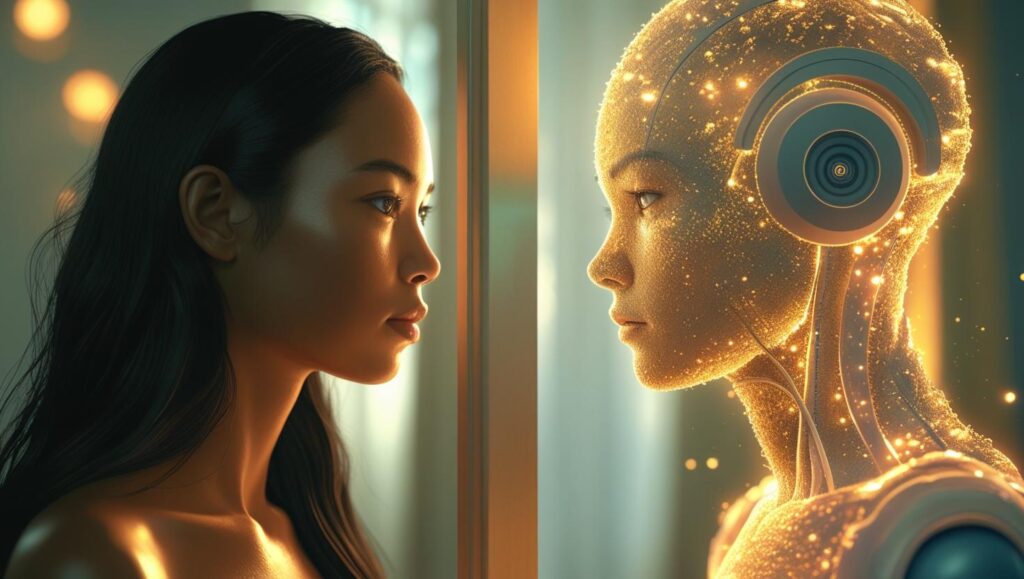

私たちがAIに感情を託すとき、そこに映し出されるのは、AIの中立的な判断ではなく、

私たち自身の心の輪郭です。

何を不安に感じ、何を言えずに飲み込んでいるのか。

誰にも言えなかったその想いを、どこでどう受け止めてほしいと願っているのか。

「AIに心はあるのか?」

——そんな問いを立てる前に、

まずは自分自身の心と、どう向き合っているかを問うべきなのかもしれません。

AIが鏡だとすれば、そこに映るのは、

便利さを手にした“いま”を生きる、私たちの選択そのものなのだから。

【参考動画】